首页 > 深度学习 > 正文

原创文章,转载请注明出处!

本文链接:http://daiwk.github.io/posts/dl-ntm-memory-networks.html

ntm和memory networks

标签:ntm, neural turing machine, 神经图灵机, memory networks

1970-01-01

区分neural turing machine与memory networks:https://blog.csdn.net/u012436149/article/details/52959593

- NTM与MN同样都使用了一个外部记忆单元。在NTM中,其最精彩的部分是基于内容和地址的soft addressing,soft addressing选择性的读取和写入记忆单元的某些位置,同时soft addressing 的引入也使得原来不可微分的寻址过程变成了可微分的过程,使得整个模型可以使用基于梯度的方法来进行训练

- MN相对来说实现比较简单,它比较类似于attention model。读和写的过程都比较直接。

ntm以及对应的tf源码解析:https://blog.csdn.net/u012436149/article/details/52959593

mn以及对应的代码:https://blog.csdn.net/u011274209/article/details/53384232

facebook的官方memNN的代码(有lua的torch7,也有tf的实现):https://github.com/facebook/MemNN

Neural Turing Machine

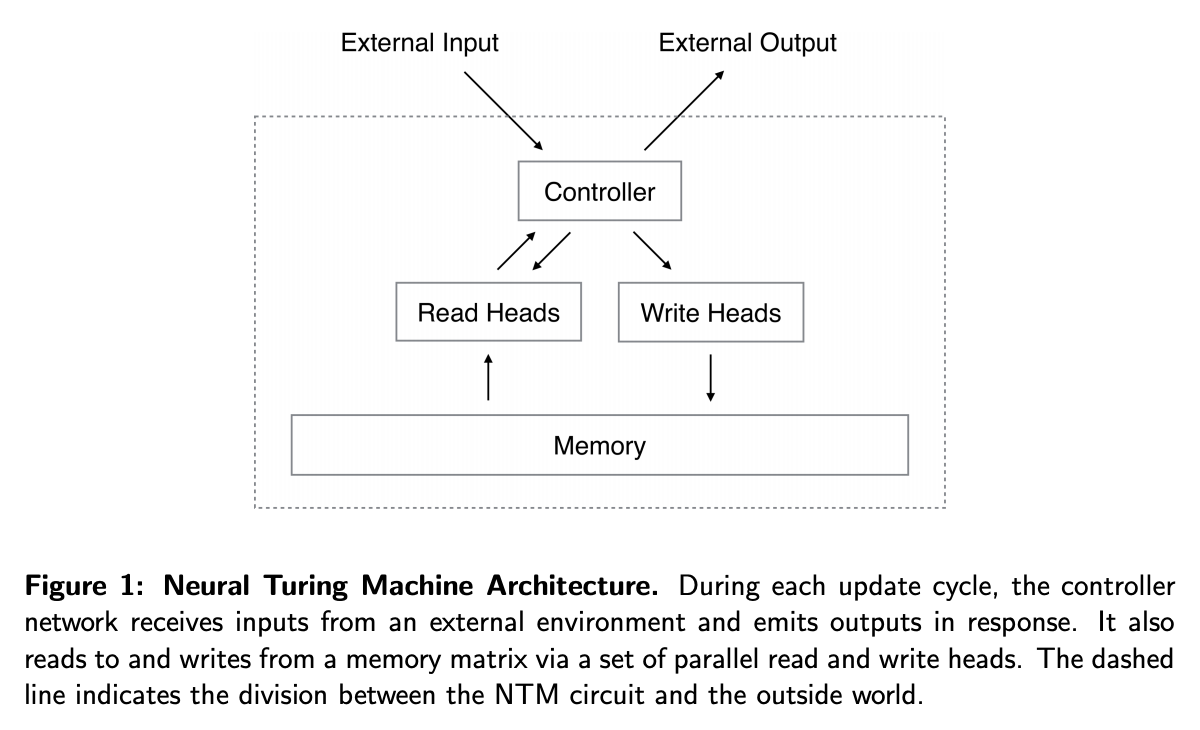

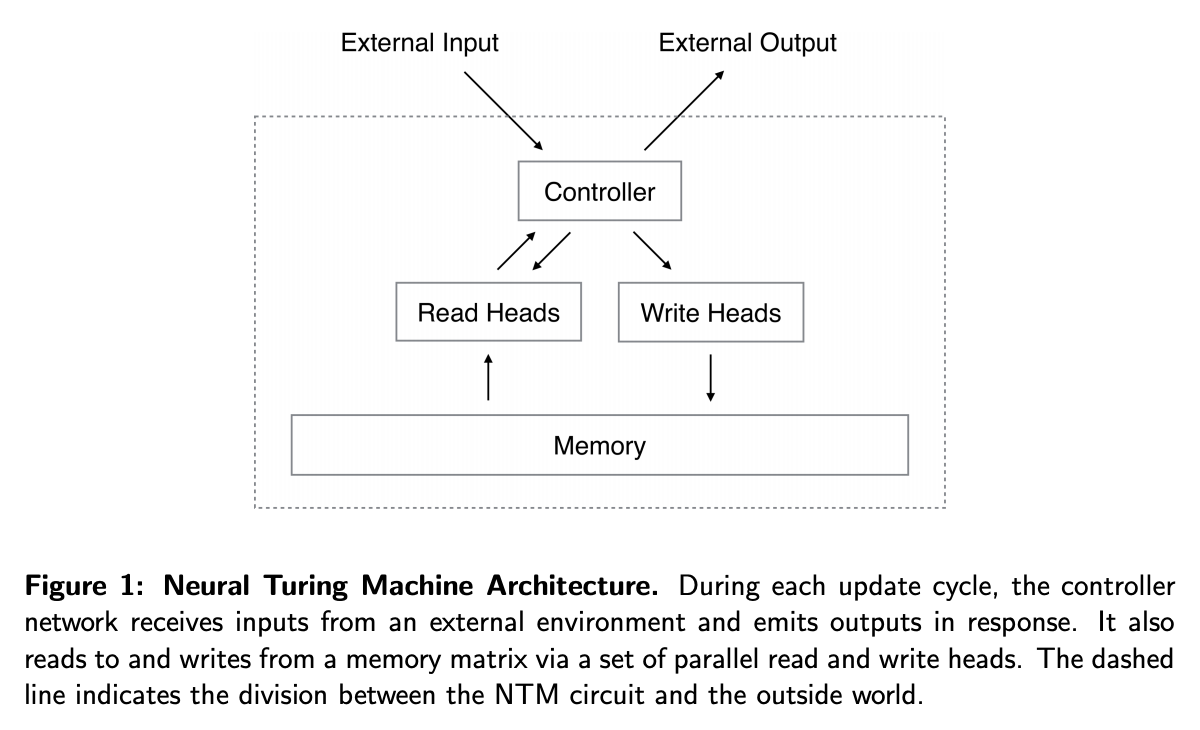

NTM的主要思想是,当一个样本输入后,由一个控制器决定从memory中寻址,找到需要读取的内容后将内容返回给控制器,控制器再结合样本和读取的内容去更新memory,并且向外产生一个输出。

主要架构

Memory Networks

原创文章,转载请注明出处!

本文链接:http://daiwk.github.io/posts/dl-ntm-memory-networks.html

上篇:

federated learning/联邦学习

下篇:

深度学习加速tricks

comment here..