首页 > 常用平台 > 正文

原创文章,转载请注明出处!

本文链接:http://daiwk.github.io/posts/platform-multitask-nlu.html

multitask nlu

标签:multitask nlu, mt-dnn, multitask

2019-02-13

目录

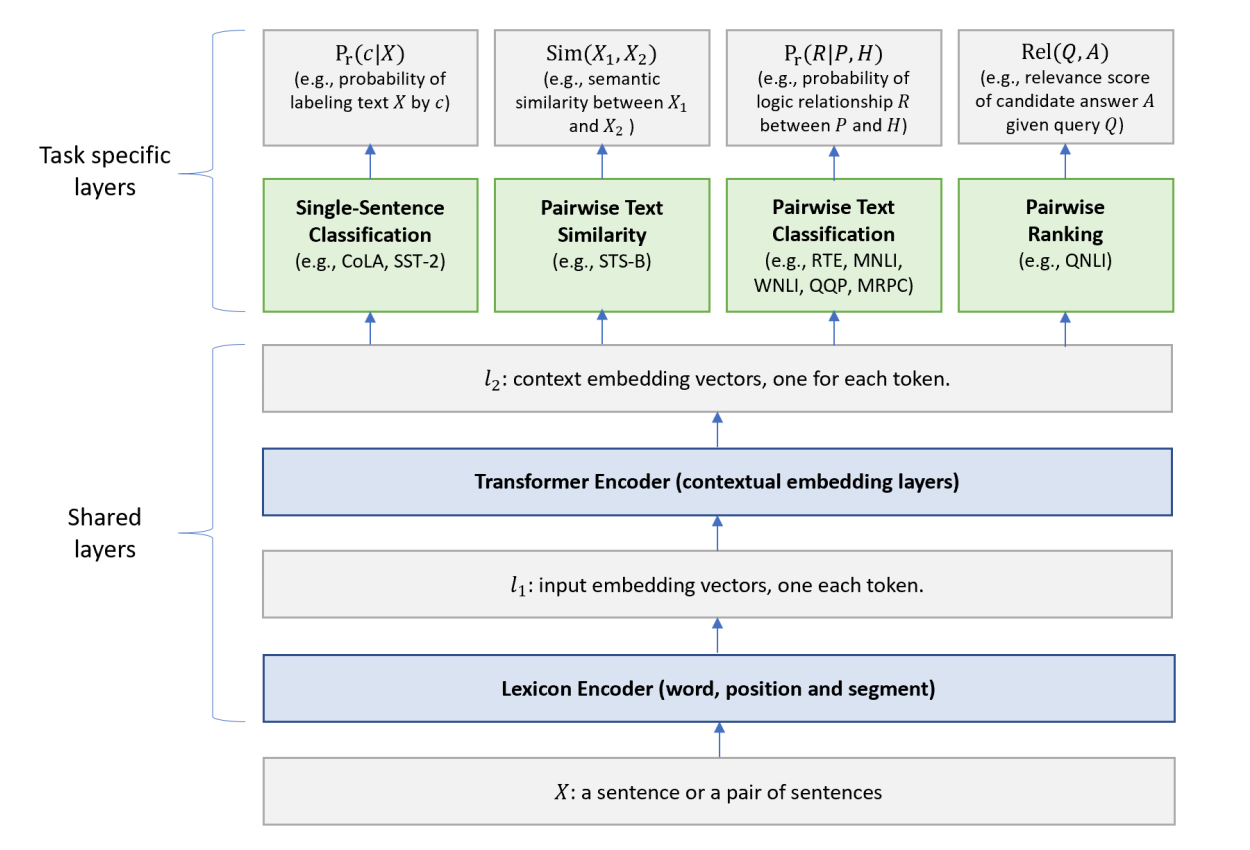

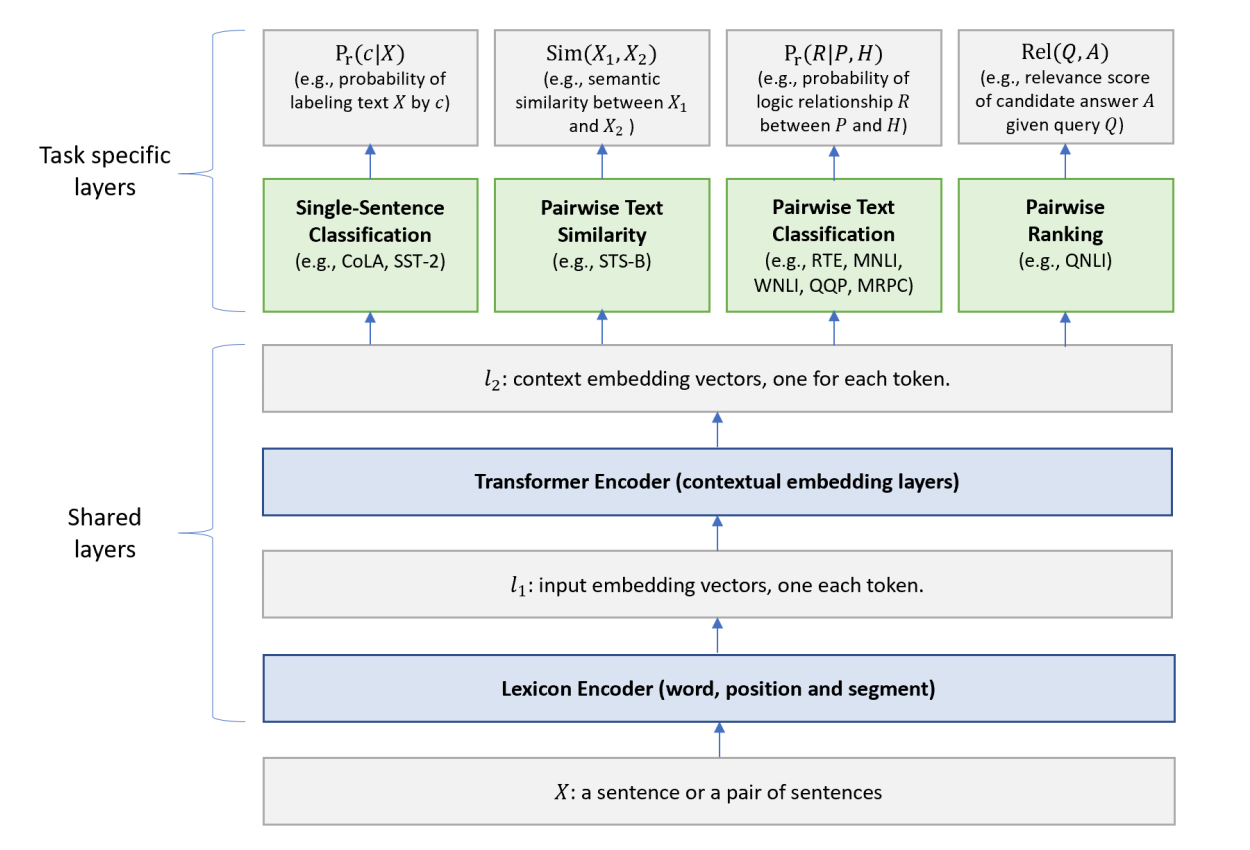

Multi-Task Deep Neural Networks for Natural Language Understanding

较低层(即文本编码层)在所有任务中共享,而顶层是任务特定的,组合不同类型的 NLU 任务,如单句分类、pair文本分类、文本相似性和相关性排序。与BERT模型类似,MT-DNN分两个阶段进行训练:预训练和微调。与BERT不同的是,MT-DNN在微调阶段使用MTL,在其模型架构中具有多个任务特定层。

单词序列(可以是一句话或者打包在一起的句子对)作为输入X,先表示为一个嵌入向量序列,其中\(l_1\)中一个向量对应一个单词。然后 Transformer编码器通过自注意机制捕捉每个单词的语境信息,在\(l_2\)中生成语境嵌入序列。这就是多任务目标函数训练得到的共享语义表征。

原创文章,转载请注明出处!

本文链接:http://daiwk.github.io/posts/platform-multitask-nlu.html

上篇:

meta learning& auto-ml

下篇:

deepgan

comment here..